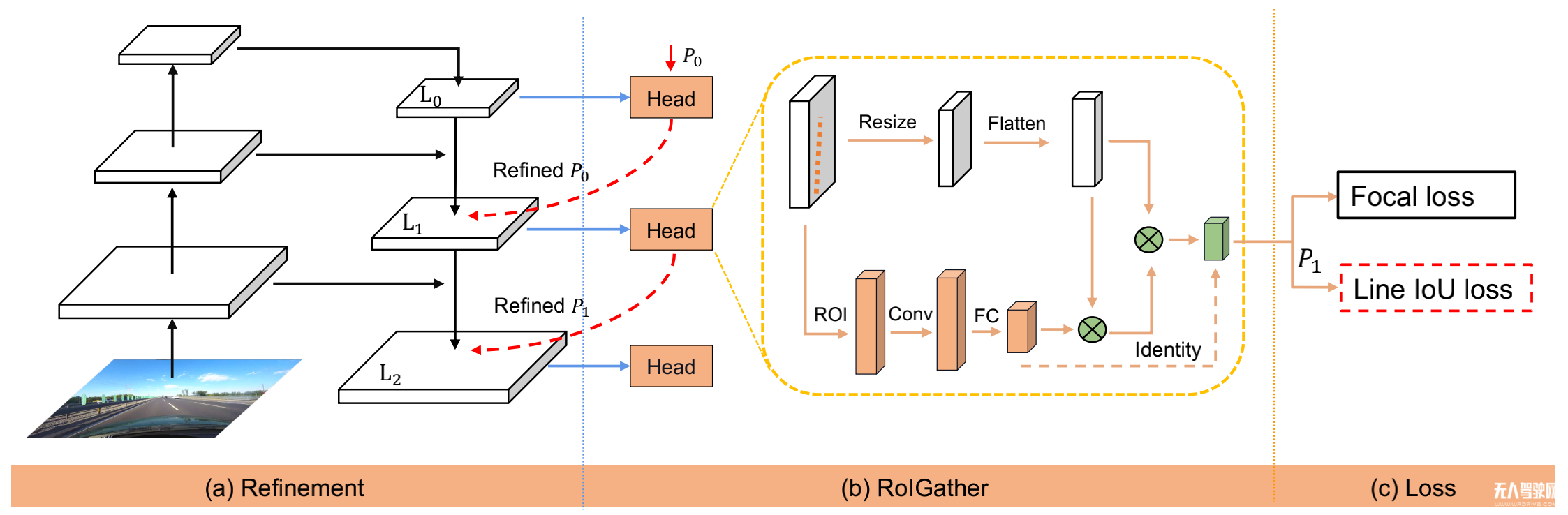

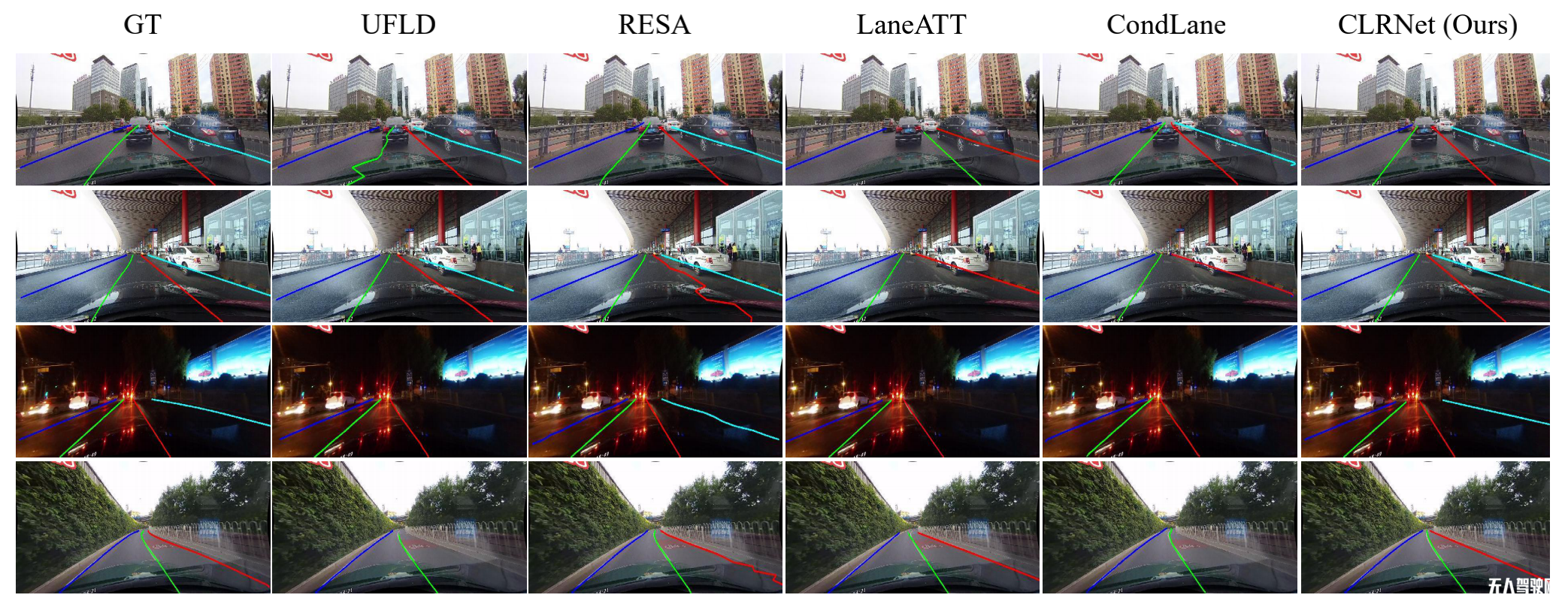

基于跨層優(yōu)化的車(chē)道線(xiàn)檢測(cè)方法

掃碼關(guān)注公眾號(hào),隨時(shí)了解最新資訊

飛步科技三篇論文入選CVPR 2022

時(shí)間:2022-03-25

來(lái)源:LSAD產(chǎn)業(yè)聯(lián)盟

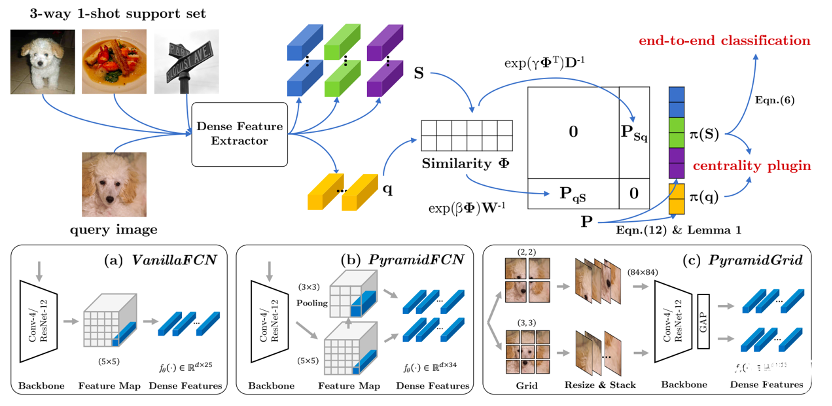

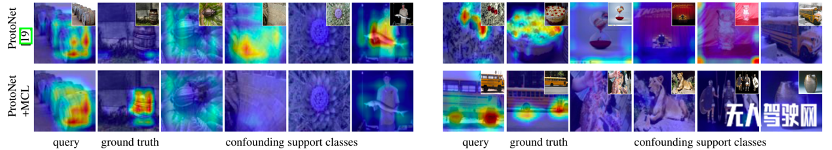

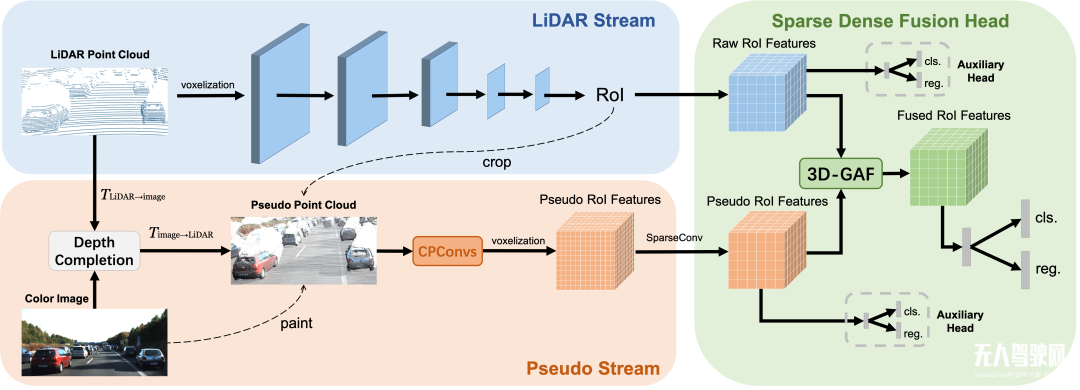

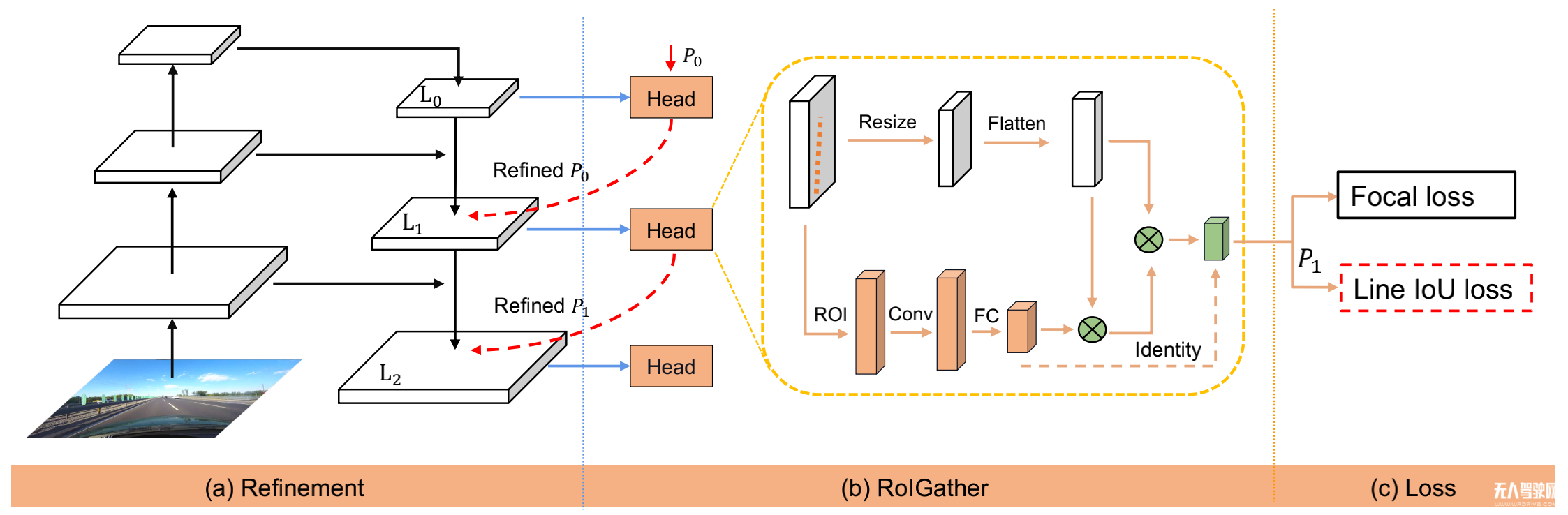

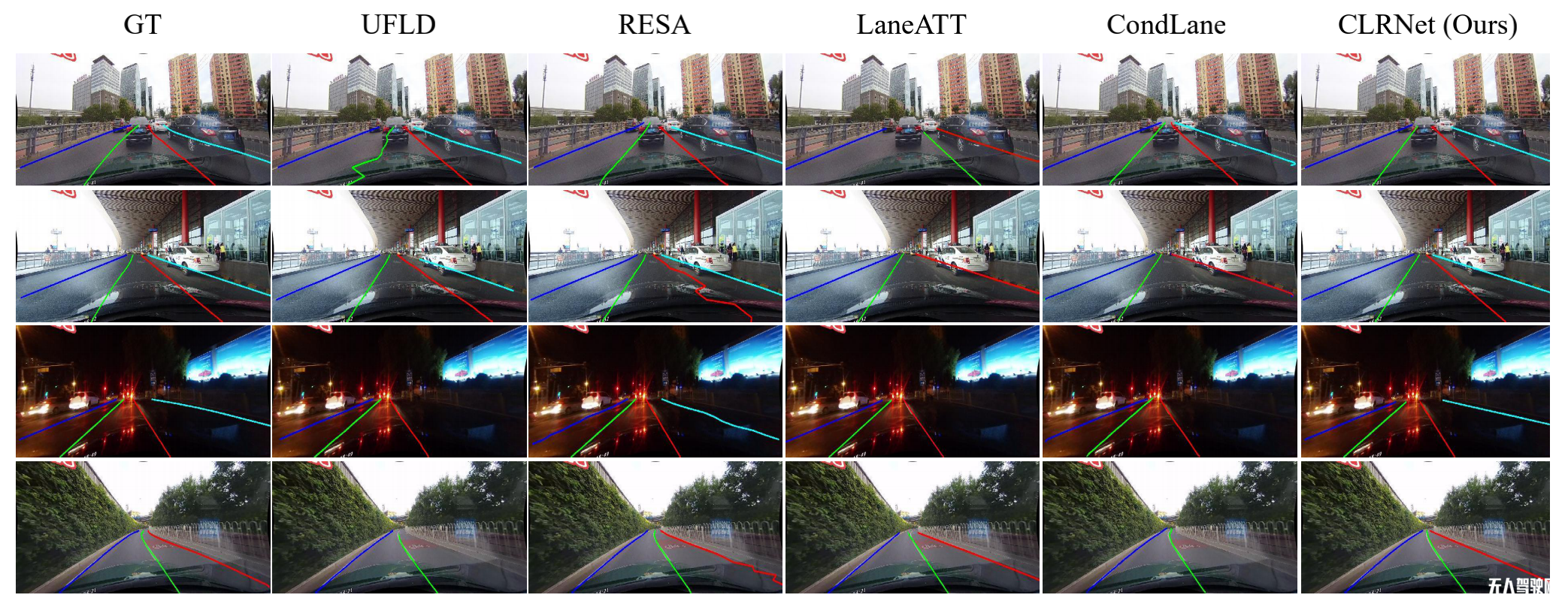

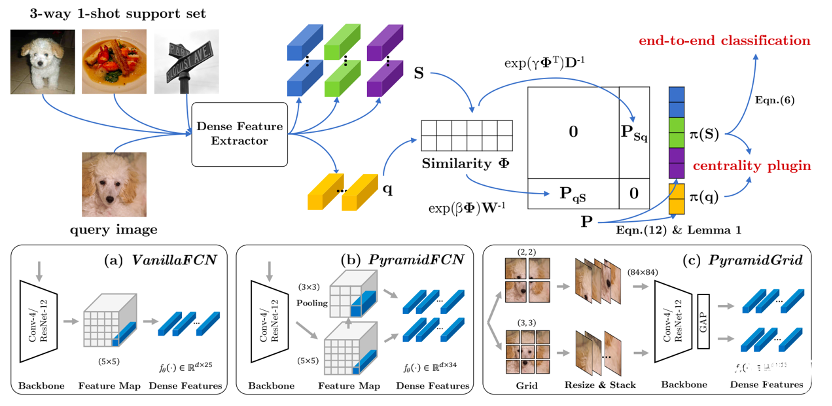

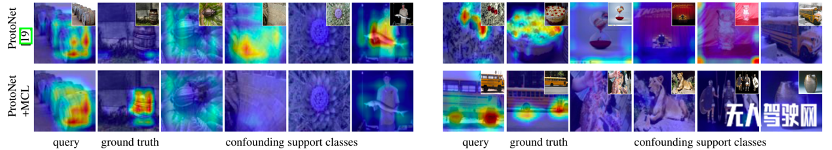

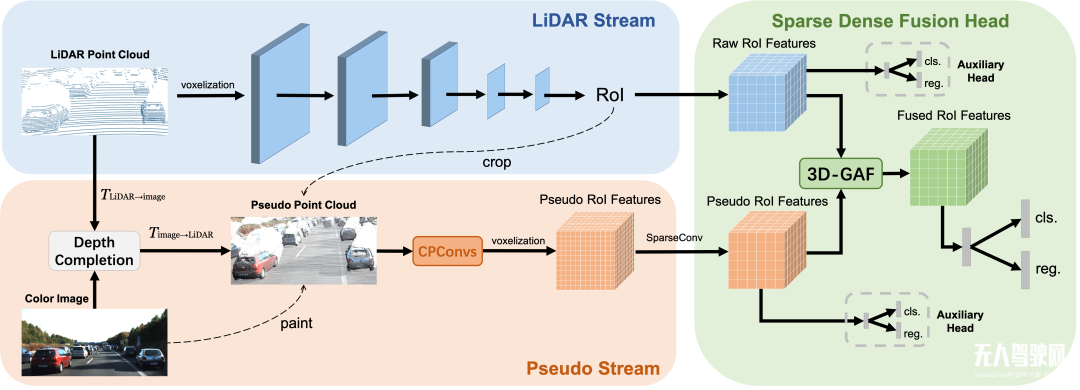

導(dǎo)語(yǔ):涉及車(chē)道線(xiàn)檢測(cè)、3D目標(biāo)檢測(cè)、少樣本分類(lèi)等與無(wú)人駕駛密切相關(guān)的技術(shù)方向。

凡本網(wǎng)注明[來(lái)源:低速無(wú)人駕駛產(chǎn)業(yè)綜合服務(wù)平臺(tái)]的所有文字、圖片、音視和視頻文件,版權(quán)均為低速無(wú)人駕駛產(chǎn)業(yè)綜合服務(wù)平臺(tái)獨(dú)家所有。如需轉(zhuǎn)載請(qǐng)與0755-85260609聯(lián)系。任何媒體、網(wǎng)站或個(gè)人轉(zhuǎn)載使用時(shí)須注明來(lái)源“低速無(wú)人駕駛產(chǎn)業(yè)綜合服務(wù)平臺(tái)”,違反者本網(wǎng)將追究其法律責(zé)任。

本網(wǎng)轉(zhuǎn)載并注明其他來(lái)源的稿件,均來(lái)自互聯(lián)網(wǎng)或業(yè)內(nèi)投稿人士,版權(quán)屬于原版權(quán)人。轉(zhuǎn)載請(qǐng)保留稿件來(lái)源及作者,禁止擅自篡改,違者自負(fù)版權(quán)法律責(zé)任。

如涉及作品內(nèi)容、版權(quán)等問(wèn)題,請(qǐng)?jiān)谧髌钒l(fā)表之日起一周內(nèi)與本網(wǎng)聯(lián)系,否則視為放棄相關(guān)權(quán)利。

關(guān)注低速無(wú)人駕駛產(chǎn)業(yè)聯(lián)盟公眾號(hào)獲取更多資訊

易控智駕率先實(shí)現(xiàn)礦區(qū)無(wú)人駕駛采運(yùn)排全流程、規(guī)模化混行混編

已在近10個(gè)礦區(qū)實(shí)現(xiàn)規(guī)模化混行混編。

新增12輛!中東首個(gè)無(wú)人集卡Q-Truck車(chē)隊(duì)擴(kuò)編

西井科技已為全球28個(gè)國(guó)家和地區(qū)提供產(chǎn)品和服務(wù)。

玉禾田0元收購(gòu)坎德拉智能科技,無(wú)人駕駛到底是“資源”還是“負(fù)擔(dān)”

由于坎德拉智能科技業(yè)績(jī)不達(dá)標(biāo),還將向玉禾田支付1000萬(wàn)元補(bǔ)償款。

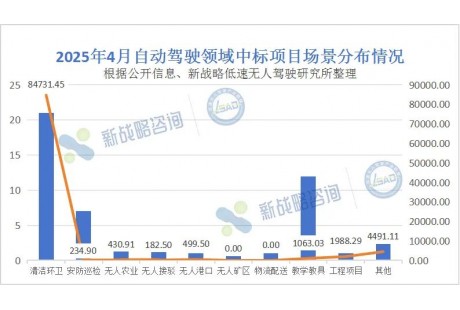

環(huán)衛(wèi)項(xiàng)目近8.5億元!4月無(wú)人駕駛領(lǐng)域中標(biāo)結(jié)果匯總

內(nèi)附詳細(xì)項(xiàng)目信息。

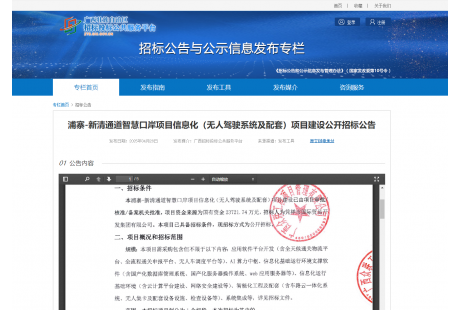

2.4億元!浦寨-新清通道智慧口岸(無(wú)人駕駛系統(tǒng)及配套)項(xiàng)目建設(shè)招標(biāo)

?5月8日?qǐng)?bào)名截止,含車(chē)路云一體化系統(tǒng)、無(wú)人集卡及配套設(shè)備設(shè)施、檢查設(shè)備等。

158臺(tái)!國(guó)內(nèi)單一碼頭最大規(guī)模IGV車(chē)隊(duì)誕生

國(guó)內(nèi)已實(shí)現(xiàn)超5個(gè)港口無(wú)人車(chē)隊(duì)規(guī)模破百。

2000臺(tái)無(wú)人車(chē)量產(chǎn)大單再落十堰,這座城市能否問(wèn)鼎“智車(chē)之都”?

當(dāng)?shù)責(zé)o人車(chē)制造基地已涵蓋配送、清掃、接駁、農(nóng)業(yè)等多個(gè)領(lǐng)域。

【7月】2025(第五屆)低速無(wú)人駕駛場(chǎng)景生態(tài)共建拓展大會(huì)

行業(yè)專(zhuān)家、企業(yè)領(lǐng)袖齊聚,開(kāi)啟低速無(wú)人駕駛發(fā)展新征程!

希迪智駕批量交付36輛無(wú)人礦卡;貴州首條無(wú)人駕駛公交線(xiàn)路將于5月4日開(kāi)通

Waymo美國(guó)單周付費(fèi)無(wú)人駕駛出行25萬(wàn)人次;希迪智駕批量交付36輛無(wú)人礦卡;中央支持自貿(mào)區(qū)深化智能網(wǎng)聯(lián)汽車(chē)道路測(cè)試;輕舟智航...

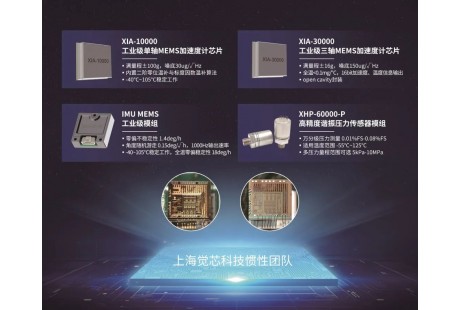

專(zhuān)注慣性器件10余年,這支團(tuán)隊(duì)上海車(chē)展首秀亮出多款“王牌產(chǎn)品”

產(chǎn)品應(yīng)用場(chǎng)景廣泛,芯片測(cè)試的數(shù)據(jù)已經(jīng)達(dá)到國(guó)內(nèi)第一梯隊(duì)。

水空協(xié)同作業(yè),高效運(yùn)維監(jiān)測(cè) I 無(wú)人船技術(shù)落地助力水利數(shù)字化、智慧化

![]()

![]() 2024-08-12

2024-08-12

護(hù)航低空經(jīng)濟(jì) | 云馳未來(lái)inTARA助力小鵬匯天飛行汽車(chē)構(gòu)建網(wǎng)絡(luò)安全新防線(xiàn)

![]()

![]() 2024-07-25

2024-07-25

一個(gè)字:酷!全球10款無(wú)座艙式無(wú)人礦卡圖鑒

![]()

![]() 2024-02-29

2024-02-29

汽車(chē)網(wǎng)絡(luò)安全持續(xù)性監(jiān)測(cè):應(yīng)對(duì)未來(lái)的挑戰(zhàn)

![]()

![]() 2023-08-11

2023-08-11

割草機(jī)器人高精定位導(dǎo)航技術(shù)研究

![]()

![]() 2022-06-02

2022-06-02

年產(chǎn)能20萬(wàn)臺(tái)?固態(tài)激光雷達(dá)刮起量產(chǎn)風(fēng)

![]()

![]() 2022-05-09

2022-05-09

物資配送&人員轉(zhuǎn)運(yùn)——倉(cāng)擎10噸級(jí)無(wú)人牽引車(chē)“進(jìn)駐”上海社區(qū)

![]()

![]() 2022-04-29

2022-04-29

優(yōu)小哥三代馳援上海高校,機(jī)器人志愿者為校園配送保駕護(hù)航!

![]()

![]() 2022-04-26

2022-04-26